Привет! Меня зовут Катя Кислицкая, я руководитель департамента Unreal Engine в студии компьютерной графики ITSALIVE. Мы занимаемся производством цифровых аватаров и маскотов для брендов.

В прошлой статье мы рассказали как работают трансляции с виртуальными персонажами. Сегодня будем говорить про оборудование, которое мы используем для своих трансляций. А еще дадим список бесплатных приложений и нейронок, с помощью которых вести трансляции с аватарами сможет любой желающий.

Какое оборудование нужно для трансляций

Так как мы говорим об анимации, странно не упомянуть мокап — захват реальных движений актера. Значительная часть работы 3D-аниматора может быть завязана на работе с ним. Игры, мультсериалы, кино, трансляции — во всех этих отраслях уже десятилетие активно используют технологии захвата движения.

Термин «мокап» — это сокращение слов motion capture, или захват движения. Для захвата мимики, тела и пальцев рук используются костюмы, шлемы и перчатки. В мокапе для трансляций тоже есть своя специфика, так что давайте сначала разберемся в видах мокапа.

Мокап-оборудование делится на профессиональное, полупрофессиональное и любительское. Любительские вещи могут быть бесплатными: например, нейросети, которые считывают движения. Но они будут не очень точными. Чем более дорогое оборудование, тем более качественно будет снято движение. То есть сам «сырой» материал будет лучше, и его надо будет меньше дорабатывать в постпродакшене.

Я думаю, что многие хотя бы раз видели актера в черном костюме, покрытом белыми шариками. Это один из способов захвата движения тела — маркерный оптический. Белые шарики — это маркеры, за которыми наблюдают камеры.

Область видимости камеры — это пирамида, вершина которой начинается в центре камеры. Если мы знаем ее координаты и можем провести линию из ее центра в один из пикселей снимаемого изображения, мы поймем, на какой линии в пространстве находится объект. Чтобы определить точное положение объекта, нужно будет провести те же манипуляции со второй камерой. В результате объект будет находится на пересечении двух линий. Если заслонить маркер для одной из камер, определить его положение в пространстве не получится. Поэтому во время съемок ставят сразу 15-20 камер и как можно больше маркеров.

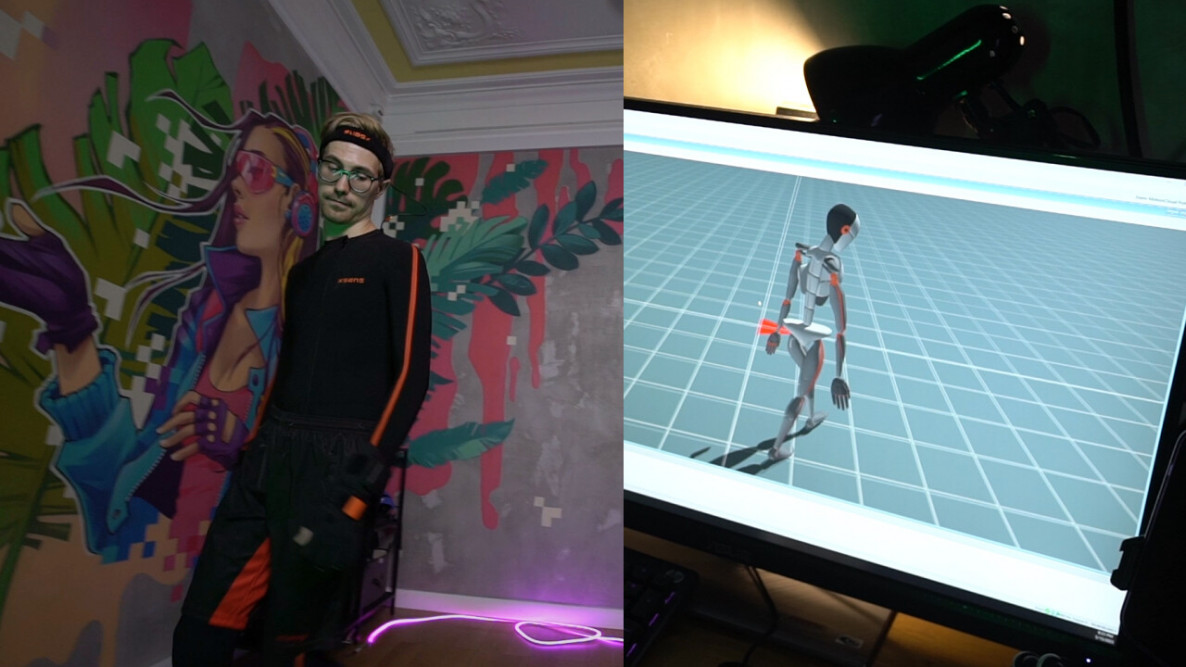

Сейчас самый популярный вид мокапа — инерциальный. Костюм захвата движения состоит из датчиков IMU (Inertial Measurement Unit), которые крепятся на части тела. Данные с них передаются в микроконтроллер, пакуются и отправляются в программу на ПК. Используя эти данные и измерения частей тела человека, мы можем достоверно реконструировать движения актера в программе.

Главное преимущество инерциального костюма захвата движения — это скорость, с которой его можно начать использовать. Его можно быстро надеть и включить в любом месте, а это особенно удобно для выездных съемок.

В последнее время активно развивается еще один вид мокапа — нейронный. Он не требует кучи профессионального оборудования: достаточно снять себя на смартфон, и нейронка сама определит положение тела в пространстве. Для дальнейшего развития в сфере можно купить мокап-костюм примерно за 600 тысяч рублей — это стоимость простенького костюма, который можно найти в продаже. Следующий шаг — это покупка профессионального костюма, который будет стоить несколько миллионов рублей и выдавать отличное качество «сырого» материала.

С захватом мимики все сложнее. Для этого инерциальный мокап не подойдет, потому что мы не сможем прикрепить датчик к каждой мышце лица и на глаза. Поэтому остаются только оптические методы. Чтобы захватить микродвижения лица, камеры не должны располагаться далеко от человека. Поэтому для записи мимики часто используют шлемы или штативы.

Теперь подробнее остановимся на оборудовании, которое используем в ITSALIVE.

Костюм захвата движения

В своей работе мы используем костюмы Xsens (и это не реклама!). Они считаются лучшими на рынке инерциальными костюмами. Есть еще несколько компаний, которые выпускают похожие костюмы: Rokoko, Perception Neuron, российская компания VARYA. Мы протестировали несколько вариантов, и больше всего нам подошел Xsens.

Подробнее про Xsens можно прочитать тут. Если коротко, главное преимущество этого костюма перед другими — это разные режимы записи. Например, костюм в режиме Single Level хорошо определяет, когда ноги актера прикасаются к полу. Без этой функции ноги аватара не будут касаться 3D-пола, а будут либо проваливаться, либо левитировать.

Но в работе с костюмом Xsens есть нюансы:

-

Он хорошо отрабатывает захват анимации, но не идеально.

Костюм чувствителен даже к самым мелким движениям. Но датчики в костюме не знают о своем абсолютном положении в пространстве. И при этом они считывают движения с ошибкой, которая увеличивается со временем. Поэтому через некоторое время работы костюма аватар не сможет, например, похлопать в ладоши, положить руки на колени или на голову.

-

Костюмы Xsens очень чувствительны к положению датчиков на теле.

Если датчик слетит или сдвинется, то придется перекалиброваться. Для этого нужно встать в Т-позу, походить восьмеркой и после этого вернуться в то же положение в Т-позу. После этого костюм начинает правильно работать, потому что датчики понимают, где они находятся в пространстве.

-

Не подойдет, если вам нужен аватар плюс-сайз.

У Xsens есть размерная сетка, но на каждый новый размер нужно докупать отдельный костюм. Для нетипичной комплекции можно крепить датчики на теле, но они часто съезжают. Поэтому мы сшили свой костюм с рядом усовершенствований: добавили части с вентилируемой сетчатой тканью, чтобы актерам не было жарко в процессе многочасовой съемки.

Шлем для захвата мимики

Чтобы захватывать мимику актера вне зависимости от того действия, которое он совершает, нужно надеть на него шлем с камерой. Бренд самого шлема не важен: это просто экипировка, которая должна хорошо сидеть на голове. Другое дело — системы записи, состоящие из камеры и софта. Их огромное количество, и лучшие решения находятся у крупных продакшн-студий по типу WETA digital и не доступны на открытом рынке.

Существуют и совсем экстремальные решения для ультрареализма, по типу фотограмметрической «сферы», как в недавнем тизере от Кодзимы. Но когда речь идет о трансляциях, важен баланс качества и стабильности системы. Сейчас с этой задачей лучше всего справляется обыкновенный IPhone, закрепленный на шлеме.

Минусы работы со шлемами для захвата мимики:

-

Он тяжелый и сильно сжимает голову.

Находиться в нем больше часа — пытка. Шлем сделан таким потому, что человеческий скальп подвижный, а для корректной работы приложения шлем должен быть плотно зафиксирован. Кроме этого, сама камера, закрепленная на длинном штативе у лица добавляет веса. Так что находиться в шлеме целый съемочный день — это испытание для актера.

У нас есть задача на будущее — сделать кастомный шлем, который будет комфортнее представленных на рынке.

-

Топорно снимает мимику.

Все технологии захвата мимики в рилтайме работают хуже, чем оффлайн мокап-системы. LiveLink Face — это официальное приложение на iPhone от Epic Games. Как и большинство нейронок, в лайве оно может захватить только 52 точки в лице, из-за чего мимика получается немного искусственной. Только с постобработкой можно добиться мягкой смены эмоций на лице аватара.

-

Нужно постоянно помнить об уровне заряда камеры на шлеме.

Шлем может работать как по проводу, так и без него. Но с проводом сильно ограничивается подвижность актера: не получится побегать или подпрыгнуть. Плюс из головы будут торчать провода, которые придется нести за собой — это ужасно неудобно. Беспроводное подключение решает этот вопрос, но чтобы все работало, нужно не отходить от компьютера больше, чем на 20 метров, и постоянно подзаряжаться.

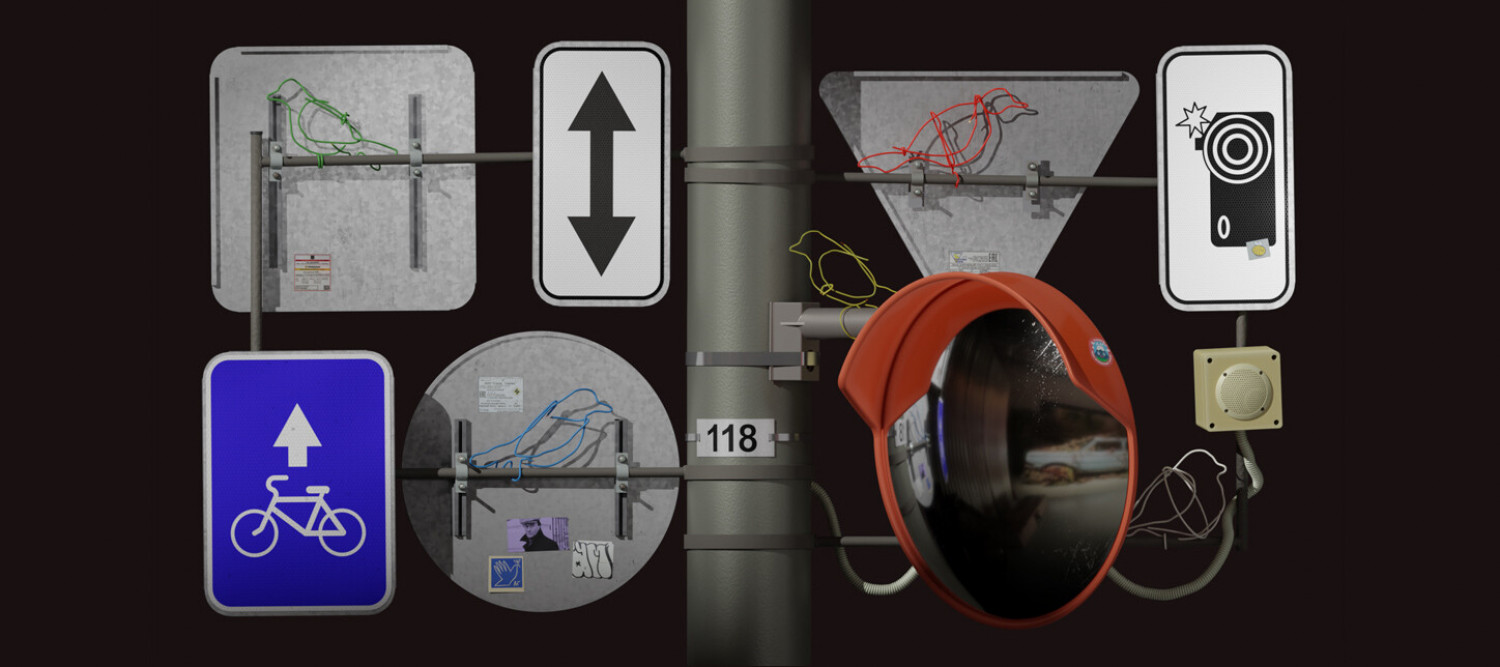

Трекер Antilatency

Любой трекер захвата движения — это датчик, который отслеживает положение предметов в пространстве. Это нужно в двух случаях:

-

У вас AR-стрим и нужно совместить движение реальной камеры и виртуальной, чтобы наложить на них движения аватара.

-

У вас VR-стрим, но вы хотите подвижную виртуальную камеру. Тогда можно повесить трекер куда угодно и транслировать положение этого предмета на движение виртуальных камер.

Мы используем трекер Antilatency. Это дешевый аналог более точного трекера Mosys StarTracker или Stype RedSpy.

Сложность работы со всеми такими трекерами в том, что для них обычно нужны маркеры, которые надо развешивать на съемочной площадке. Для использования Mosys или Redspy нужно наклеивать светоотражающие стикеры на потолок, стены или пол. У Antilatency решение более изящное: в качестве маркера выступает специальный пол со светодиодами.

Кроме этого, нужно провести процесс калибровки датчиков, который может занять несколько часов. Именно поэтому для съемок чаще всего строят павильон, в котором ставят маркеры один раз и не отклеивают их до конца съемок.

Еще один минус — они достаточно дорогие. Их могут себе позволить только крупные студии или телеканалы.

Компьютеры

Помимо специального оборудования мы используем ПК с определенными характеристиками:

-

Видеокарта NVidia GeForce RTX 4090.

-

Процессор AMD Ryzen 9 7950X.

-

64 Гб оперативной памяти.

-

Водяное охлаждение.

-

Карта захвата Blackmagic DeckLink 8K Pro или AJA KONA 5.

Для каждой трансляции нужно разное количество компьютеров. Обычно рассчитываем количество ПК по количеству ракурсов с аватаром, прибавляем по одному компьютеру для мокапа и для монтажа и вывода видеосигнала.

Сейчас компьютеры перевозим в обычных корпусах, но в планах есть сборка кастомных системных блоков, которые могут храниться в одной рэковой стойке на колесиках. Это облегчит перевозку и сделает ее еще безопаснее.

Как часто выходит новое оборудование

В видеопродакшне обычно растут «вширь»: то есть, если уже есть один костюм Xsens, то докупают второй и третий. Потому что в какой-то момент продакшн-студия сталкивается с тем, что нужно записать взаимодействие двух аватаров: например, драку или погоню.

Рынок мокап-оборудования очень маленький, что-то новое выходит редко и стоит дорого. Это происходит потому, что это оборудование чаще всего используется в кинопроизводстве, где у инвентаря должен быть троекратный запас прочности. Поэтому продакшн скорее будут использовать проверенное временем оборудование, чем рисковать и внедрять что-то новое.

В рилтайме выходит намного меньше новинок, чем в оффлайн-мокапе. Потому что обычно они создаются для людей из классического продакшна, которые делают анимационные ролики или геймдев. Стримы пока что — это очень узкая сфера.

Лучшее оборудование разрабатывают большие студии, но оно не попадает на широкий рынок. Например, у Weta Digital и у других есть свои системы, которые считаются лучшими в мире. Сейчас они становятся более популярными, поэтому на рынок выходят все более доступные решения — например, новые нейросети. Их можно использовать дешево или бесплатно и тестировать сразу после выхода. Сейчас самые хайповые — это Deep Motion и Move AI. Они позволяют захватывать движение с помощью 1-2 обычных камер.

Бесплатный сетап для трансляций

На самом деле, без костюмов захвата движения и другого оборудования можно обойтись. Но только в случае, если ваша цель — стримить на любительском уровне. Для качественного результата придется докупать оборудование.

Мы собрали бесплатный сетап, который подойдет для новичков в рилтайме. С ним вы сможете записывать ролики с аватаром, выходить в лайв на Twitch или даже на совещания в зуме.

Для создания аватаров, похожих на аниме-персонажей, нужно минимум оборудования: только веб-камера или телефон, на который нужно установить любое из этих приложений:

Если хотите углубиться в процесс работы с аватаром и создать уникального витьюбера, идите по такому пути:

-

Создаем собственного metahuman на этом сайте.

-

Открываем Unreal Engine, скачиваем своего metahuman через Quixel Bridge.

-

Качаем LiveLink Face на IPhone или ищем альтернативу на Android, которая считывает ARkit-блендшейпы.

-

Скачиваем на телефон или компьютер приложение для рилтайм мокапа тела.

-

Подключаем приложения к Unreal Engine — для этого могут потребоваться специальные плагины, они обычно указаны на сайтах приложений.

-

Подключаем анимацию к metahuman: туториалы для каждого из приложений обычно есть на сайтах.

-

В OBS добавляем захват игры (Game Capture), выбираем окно Unreal Engine и начинаем стримить на платформы. Если нужно будет записать анимацию для дальнейшего видео, используйте OBS или функцию take recorder в Unreal Engine.

Нейронки для мокапа в Realtime:

Надеюсь, мне удалось показать, что за трансляциями с аватарами скрыт целый мир сложного виртуального продакшна, для которого нужны опытные инженеры, 3D-моделлеры и куча оборудования.